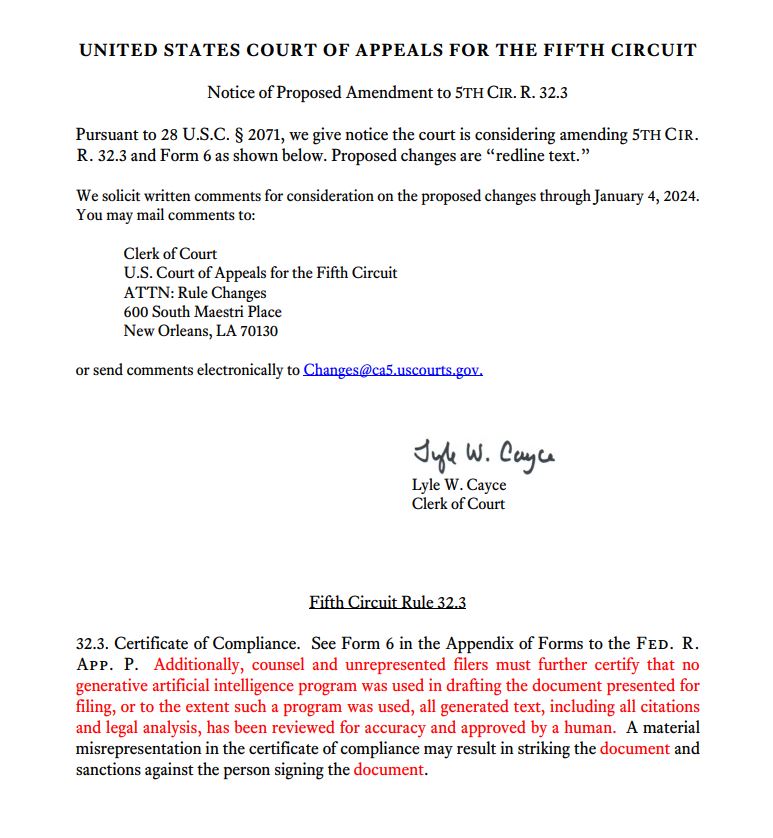

Федеральный апелляционный суд в Новом Орлеане рассматривает предложение, которое обяжет юристов подтверждать, использовали ли они программы искусственного интеллекта для составления записок, подтверждая либо независимую человеческую проверку точности текста, сгенерированного ИИ, либо отсутствие зависимости от ИИ в их судебных материалах.

В уведомлении, опубликованном 21 ноября, 5-й окружной апелляционный суд США раскрыл, по-видимому, первое предложенное правило среди 13 федеральных апелляционных судов страны, в котором основное внимание уделяется регулированию использования инструментов генеративного искусственного интеллекта, включая ChatGPT от OpenAI. адвокатами, выступающими в суде.

Предлагаемое постановление будет применяться к адвокатам и истцам без юридического представительства, предстающим перед судом, и обязывает их подтверждать, что если при подаче заявления использовалась программа искусственного интеллекта, то как цитаты, так и юридический анализ оценивались на предмет точности. Адвокаты, которые предоставляют неточную информацию о своем соблюдении правила, могут быть признаны недействительными, и могут быть наложены санкции, как указано в предлагаемом правиле. Пятый округ открыт для общественного обсуждения предложения до 4 января.

Введение предложенного правила совпало с тем, что судьи по всей стране обратились к быстрому распространению программ генеративного искусственного интеллекта, таких как ChatGPT. Они изучают необходимость гарантий при использовании этой развивающейся технологии в залах судебных заседаний. Проблемы, связанные с использованием ИИ юристами, приобрели известность в июне, когда два адвоката из Нью-Йорка столкнулись с санкциями за подачу юридического документа, содержащего шесть сфабрикованных цитат из дел, подготовленных ChatGPT.

В октябре Окружной суд Восточного округа Техаса ввел правило, вступающее в силу с 1 декабря, обязывающее юристов использовать программы искусственного интеллекта для «оценки и аутентификации любого компьютерного контента».

Согласно заявлениям, сопровождающим изменение правила, суд подчеркнул, что «часто результаты таких инструментов могут быть неверными с фактической или юридической точки зрения», и подчеркнул, что технология искусственного интеллекта «никогда не должна заменять абстрактное мышление и способности юристов решать проблемы».

Журнал: Обучайте модели ИИ продавать как NFT, LLM — это большие лживые машины: AI Eye

Источник