Пара исследователей из Университета Цукуба в Японии недавно создали систему управления портфелем криптовалют на основе искусственного интеллекта, которая использует данные о цепочке для обучения, что, по словам ученых, является первой в своем роде.

Названная CryptoRLPM, сокращенно от "Cryptocurrency reinforcement learning portfolio manager", система искусственного интеллекта использует метод обучения под названием "reinforcement learning" для внедрения данных о цепочке в свою модель.

Обучение с подкреплением (RL) - это парадигма оптимизации, при которой система искусственного интеллекта взаимодействует со своим окружением - в данном случае, портфелем криптовалют - и обновляет свое обучение на основе сигналов о вознаграждении.

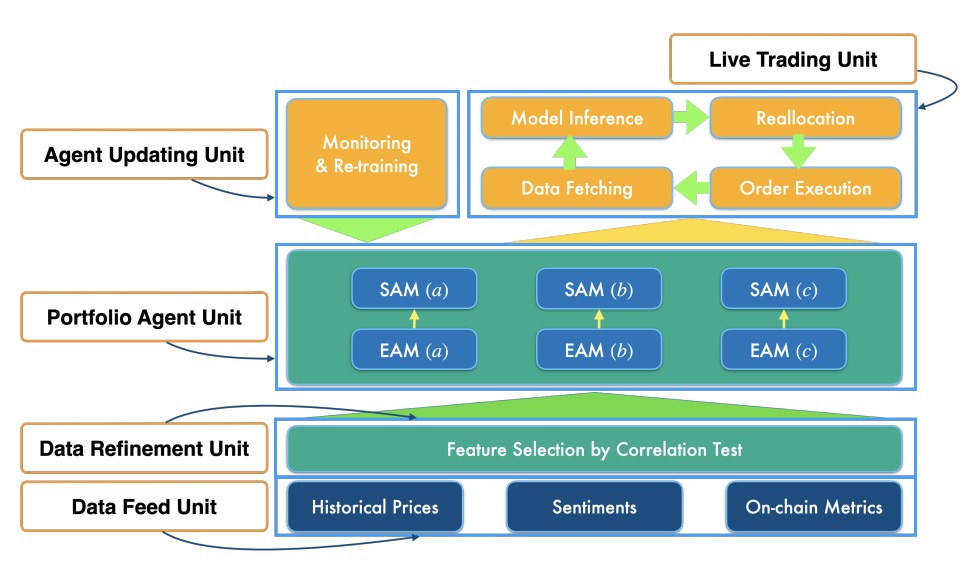

CryptoRLPM применяет обратную связь от RL во всей своей архитектуре. Система состоит из пяти основных блоков, которые работают вместе для обработки информации и управления структурированными портфелями.

Эти модули включают блок подачи данных, блок уточнения данных, блок портфельного агента, блок реальной торговли и блок обновления агента.

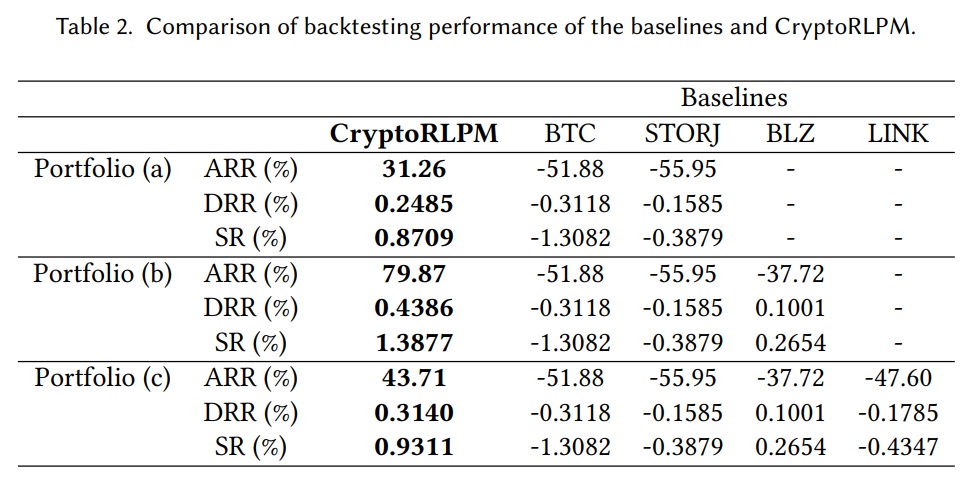

После разработки ученые протестировали CryptoRLPM, назначив ему три портфеля. Первый содержал только Bitcoin (BTC) и Storj (STORJ), второй - BTC и STORJ с добавлением Bluzelle (BLZ), а третий - все три, а также Chainlink (Link).

Эксперименты проводились в период с октября 2020 года по сентябрь 2022 года с тремя отдельными фазами (обучение, валидация, бэктестинг).

Исследователи измерили успех CryptoRLPM по сравнению с базовой оценкой стандартной работы рынка с помощью трех показателей: "накопленная норма прибыли" (AAR), "ежедневная норма прибыли" (DRR) и "коэффициент Сортино" (SR).

AAR и DRR - это наглядные показатели того, сколько актив потерял или приобрел за определенный период времени, а SR - доходность актива с учетом риска.

Согласно препринту исследовательской работы ученых, CryptoRLPM демонстрирует значительные улучшения по сравнению с базовой производительностью:

"В частности, CryptoRLPM показывает улучшение ARR по меньшей мере на 83,14%, улучшение DRR по меньшей мере на 0,5603% и улучшение SR по меньшей мере на 2,1767 по сравнению с базовым Bitcoin".Источник